Bedrägerier på nätet är inget nytt. Men med generativ AI har bedragare fått ett kraftfullt verktyg för att uppgradera sina gamla bluffar – och göra dem svårare att avslöja. Här är några typer av AI-relaterade bedrägerier att se upp för.

Utvecklingen av generativa AI-verktyg har hjälpt oss människor på flera olika sätt. Användningsområdena är många. Verktygen hjälper oss bland annat att skapa text, ljud, bilder och video. De används för att sammanfatta och översätta texter – och för att det är kul.

Men precis som många andra uppfinningar kan även generativ AI användas för ohederliga syften, av bedragare som vill lura oss.

Vad är generativ AI?

Generativ AI är en sorts artificiell intelligens som använder data den lärts upp på för att skapa (generera) något nytt. Det kan handla om text, bild eller video. ChatGPT, Midjourney och Gemini är kända exempel på generativa AI-verktyg.

Jan Olsson är kriminalkommissarie vid Nationellt it-brottscentrum hos Polisen. Enligt honom hittar AI inte på några nya bedrägerier. I stället hjälper tekniken bedragarna att genomföra gamla bluffar på mer effektiva sätt och sprida dem till fler människor snabbare.

– Bedrägerier har funnits sedan urminnes tider, det är bara nya varianter som kommer. När datorn och internet slog igenom kunde bedragarna plötsligt börja skicka bluffmejl till människor. Nu är det i stället AI som gör det mycket lättare för dem att vilseleda folk, säger han.

Här är olika typer av AI-relaterade bedrägerier att se upp för.

Bluffmejl och falska sms

Falska mejl och sms hör till de vanligaste formerna av bedrägeriförsök. Tidigare har man ofta kunnat avslöja sådana bluffar för att de innehåller felstavade ord, konstig grammatik och andra språkliga misstag. Men detta har förändrats. Med hjälp av AI kan bedragare skicka ut massor av perfekt skrivna mejl och sms – på alla möjliga språk.

– Det kostar inget att skicka tusentals mejl och ofta räcker det med att någon går på bluffen för att det ska vara lönsamt för bedragaren. Därför kommer även vanliga bluffmejl fortsätta finnas i framtiden, också sådana där man undrar hur någon kan tro på dem, säger Jan Olsson.

Så kan AI användas för telefonbedrägerier

I telefonbedrägerier utger sig bedragaren ofta för att vara någon du litar på eller är beroende av. Det kan till exempel handla om din bank, en myndighet eller ett välkänt företag.

Med AI-teknik har dessa bedrägerier fått en ny dimension. I stället för att skådespela och ljuga om vem de är och var de ringer ifrån kan bedragare nu förfalska röster och låta som verkliga personer – till exempel ditt barn eller en kollega.

Ett exempel skulle kunna vara att bedragare ringer upp en person och låter precis som dennes vuxna barn. Historien de berättar kan vara att de blivit stående med bilen och behöver pengar till bärgning.

Historierna kan såklart variera, men ofta handlar det om en påhittad krissituation där den som ringer säger sig behöva pengar snabbt. När en förälder tror sig höra sitt eget barn be om hjälp är det inte konstigt att denne blir lurad.

En annan tänkbar variant är att bedragarna ringer någon på ekonomiavdelningen hos ett företag. Med hjälp av den förfalskade rösten utger de sig för att vara företagets vd som behöver hjälp med en större pengaöverföring. Överföringen sägs vara en del av en viktig affär, men pengarna hamnar förstås hos bedragarna.

Enligt Jan Olsson ligger kändisar och de som jobbar på höga positioner i näringslivet mest i riskzonen för att få sina röster förfalskade. Samtidigt är det svårt att veta hur många "vanliga" människor som faktiskt fått sina röster kopierade.

En sak som står klart är att väldigt många människors röster finns att hitta ute på nätet – framför allt i de videor som många lägger ut på sociala medier. Det krävs också bara några sekunders ljud för att skapa en trovärdig röstklon.

Bedragare skapar falska videor med AI

Med de generativa AI-verktygen har det blivit lättare än någonsin för bedragare att skapa falska videor som visar en person eller situation som aldrig ägt rum på riktigt.

Att något finns på film uppfattas ofta som ett bevis på att det faktiskt har hänt. Därför kan sådana här videor – som ibland också kallas deepfakes – vara mycket effektiva.

På samma sätt som med AI-klonade röster kan en bedragare skapa en videoklon av en person och ringa ett videosamtal till en familjemedlem, vän eller kollega. Videon ger ett extra lager av trovärdighet och bluffen skulle även här kunna gå ut på att be om pengar för att lösa en kris.

Bedragare kan också genomföra mer avancerade varianter med AI-kloner i videosamtal eller videomöten. I början av 2024 rapporterades till exempel att en anställd på ett finansbolag i Hongkong lurades att föra över 25 miljoner dollar till bedragare efter ett möte där han pratat med deepfakes av sin chef och flera kollegor.

Jan Olsson påpekar dock att bedragarna vid både video- och röstbedrägerier inte vill prata längre än nödvändigt, av goda anledningar.

– Om bedragarna bara behöver prata eller synas helt kort är det inte alls svårt att få de sekunderna att bli perfekta. Men om samtalet håller på längre tid är det lättare att se och höra att något inte stämmer. Det är inte bara för att själva videon kanske börjar fallera lite. Vi kan känna igen hur någon vi känner brukar röra sig och prata, säger han.

AI-verktygen utvecklas dock snabbt och därför är det viktigt att vara vaksam när ett samtal börjar handla om överföringar av pengar.

AI-videor av kändisar lurar dig

Det är vanligt att bedragare skapar falska videor med kändisar, eftersom många har stort förtroende för dem. Dessutom finns det redan gott om videor av dem på nätet, vilket gör det enkelt att återskapa deras utseende och röst med hjälp av AI.

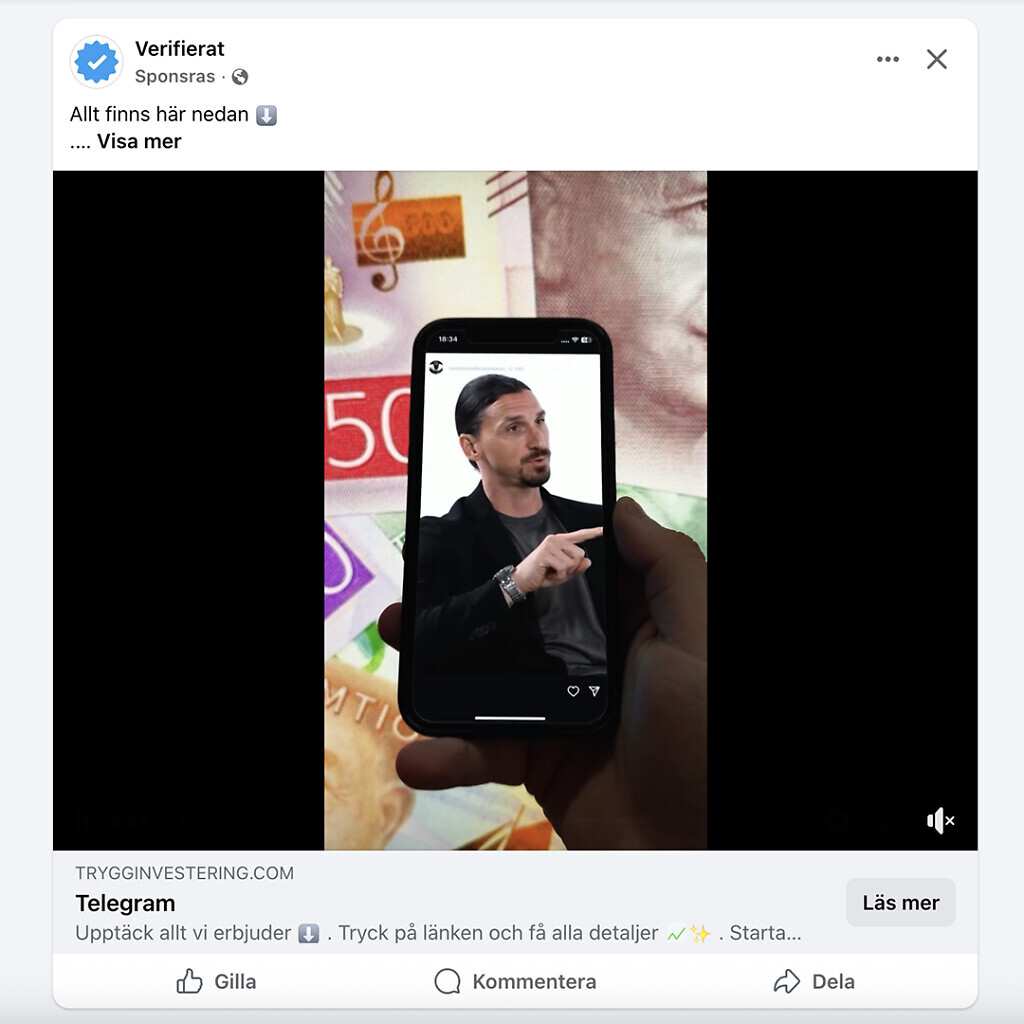

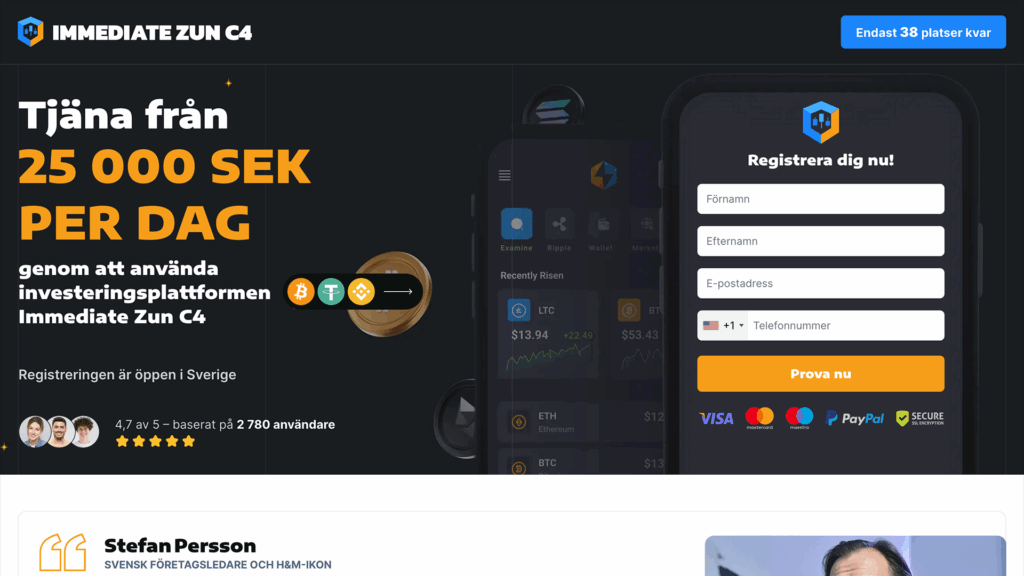

Ett vanligt exempel är investeringsbedrägerier. Några av de kändisar som utnyttjats i sådana bluffannonser är Zlatan, Leif GW Persson och Elisabeth Svantesson. I de falska videoannonserna ser det ut som om de alla erbjuder en exklusiv chans till snabba pengar genom en investering. Men allt är förstås fejk.

På samma sätt kan bedragare skapa falska reklamfilmer där kändisar ser ut att rekommendera produkter som egentligen inte finns.

AI öppnar helt nya möjligheter för sex-utpressning

Ett vanligt bedrägeri som förekommer över hela världen går ut på att människor får ett bluffmejl där bedragarna påstår att de smygfilmat personen med datorns inbyggda kamera under besök på porrsidor. I mejlet kräver de pengar för att inte sprida den påstådda videon till andra. Någon video finns dock inte – allt är påhittat.

Med hjälp av AI-verktyg har möjligheten till utpressning på sextemat uppgraderats dramatiskt. Med generativa AI-verktyg kan en persons ansikte enkelt läggas in i en pornografisk film på ett verklighetstroget sätt. Därefter försöker bedragarna pressa personen på pengar genom att hota med att sprida filmen.

Bluffsajter får en uppgradering med AI

Fejkade sajter, falska nätbutiker och bedrägliga aktieplattformar är viktiga delar i många bedrägerier.

Med generativa AI-verktyg kan bedragare enkelt skapa proffsiga och trovärdiga webbplatser efter sina behov. Om en bluffsajt har snygg design, korrekt språk och liknar de seriösa webbplatser vi brukar besöka ökar risken kraftigt att människor blir lurade.

Förutom att skapa text, bild och video till sajten kan AI också användas för att bygga en övertygande kundtjänst. En så kallad chattbot — ett program som via ett chattfönster svarar på besökares frågor — ökar trovärdigheten för falska sajter.

Romansbedrägerier görs mer trovärdiga med AI

Romansbedrägerier är en väldigt utstuderad form av bedrägeri. I ett sådant lägger bedragare ner mycket tid och möda på att få någon att bli förälskad i en helt påhittad person. Poängen är att den falska personen senare ska kunna be sin ovetande partner om pengar. Bedragare hittar ofta sina offer på dejtingsajter och sociala medier, och kan använda AI för att göra sina falska profiler mer övertygande.

Den påhittade personen framställs ofta som rik och sägs ha ett respektingivande yrke, till exempel läkare eller militär. Att med AI skapa bilder och videor som stödjer den fabricerade historien hjälper bedragarna mycket. Med välgjorda deepfake-videor kan de till och med få till videosamtal som ser verkliga ut — något som romansbedragare i regel annars undviker.

Hur undviker jag att bli drabbad av AI-bedrägerier?

Även om möjligheterna att luras har blivit större med hjälp av generativ AI tror Jan Olsson inte att människor behöver gå runt och ständigt oroa sig. Enligt honom är kunskap om vad som går att göra med tekniken ett viktigt skydd. När man känner till att till exempel röster och videor kan förfalskas och användas i bedrägerier minskar risken att bli lurad.

– Det bästa är att vara sunt misstänksam och lägga märke till saker som känns konstiga. Blir man kontaktad av vad man tror är en person man känner, men på en ovanlig tid? Är det något i samtalet som sticker ut och framför allt, handlar det om pengar? Då ska man börja bli misstänksam, säger han.

Så skyddar du dig mot AI-bedrägerier

- Var medveten. Det är viktigt att känna till att den här tekniken finns och att den kan användas för att göra väldigt trovärdiga förfalskningar.

- Var sunt misstänksam. Var särskilt uppmärksam på ovanliga och konstiga situationer. Inte minst om någon ber dig föra över pengar eller identifiera dig med ditt bank-id.

- Använd aldrig ditt bank-id på uppmaning av någon som ringt upp dig. Du kan inte veta vad det används för att godkänna, eller vem det är som egentligen ringer.

- Om du jobbar på ett företag – följ den policy som finns även om du tror att det är din chef som ringer. Föreslå att du ringer tillbaka till chefen – detta kallas att motringa.